没激活码?「Manus」类应用本地部署,用NAS打造一人企业工作流!

大家好,这里是Cherry,喜爱折腾、玩数码,热衷于分享数码玩耍经验~

前言

这几天,继DeepSeek-R1、QwQ-32B之后,又一款通用性AI代理工具——Manus,火了。

这款基于多智能体的架构(Multiple Agent)的AI代理工具,据称可以自动操作电脑执行多种任务,并输出数个高效的成品。

但实际情况如何?Manus到底行不行,实际体验如何?是真真切切的AI应用集成,还是只是币圈的又一轮诈骗?这些咱们都说不上,毕竟没机会体验到,也没有那好几万去买个所谓的邀请码。

不过既然左脚已经迈入了AI时代,如果不接触和尝试一下AI Agent带来的便利,那多少会有点被时代所抛弃的感觉。

相比较于Manus,市面上还有三款非常成熟的Agent框架——Dify、Coze和FastGPT。

前两者是基于AI的零代码开发平台,后者是基于LLM的知识库问答系统,三者均经受过国内外广大网友考验,比起Manus来更真实,也更接地气。

今天,我们围绕如何本地化部署Dify,并发布一个属于自己的AI应用,来体验一下“一人公司”的乐趣。

关于部署机

本次我们部署的设备为铁威马F6-424 MAX。作为铁威马最新的一代NAS产品,铁威马F6-424 MAX采用了i5-1235U处理器,拥有10核12线程的超强处理能力,最大支持64GB DDR5内存,可以轻松实现存储、docker、虚拟机等生产能力。

F6-424 Max拥有6个机械盘位和2个M.2固态硬盘,最大可扩容至132T存储,足以满足小型企业的存储需求。在接口方面,提供了双10Gbps网口,以及10Gbps速率的 Type Ax2,Type-Cx1,无论是通过网络还是数据线,都可以享受高速的数据传输质量。

关于Dify

Dify 是一个开源的大语言模型(LLM)应用开发平台,它致力于为开发者提供一站式、低代码甚至无代码的 AI 应用开发体验。

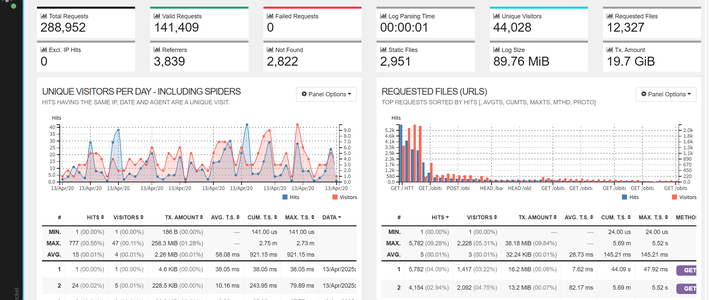

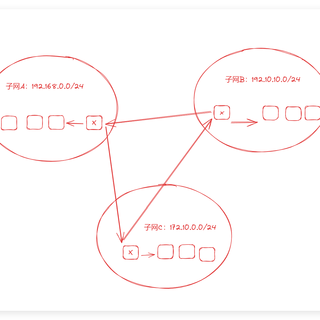

通过容器化部署,我们可将AI代理完整下沉至NAS设备,既避免了隐私数据上云的风险,又降低了30%以上的运营成本。

一、铁威马配置Docker Manager

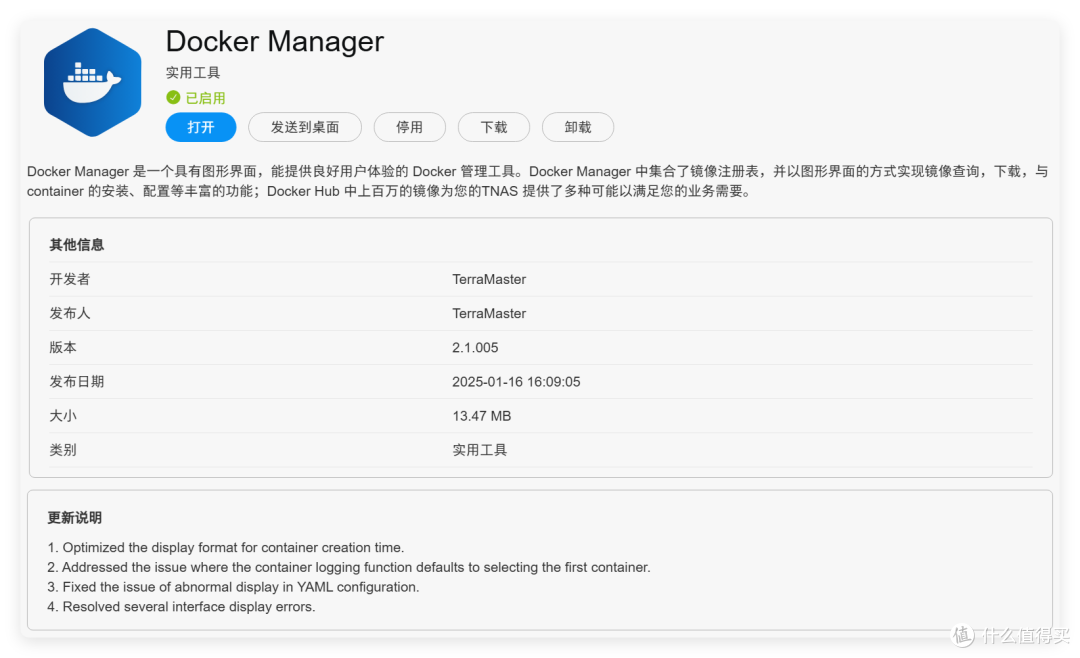

1、初始Docker Manager

首先我们在铁威马NAS里安装Docker Manger,该应用是基于Docker Engine的compose管理工具。

Docker Engine是原来的Docker应用,路径在/Volume1/@apps/DockerEngine下面,后续我们修改daemon.json也需要到这目录下操作,原来的/etc/docker/daemon.json是无效的。

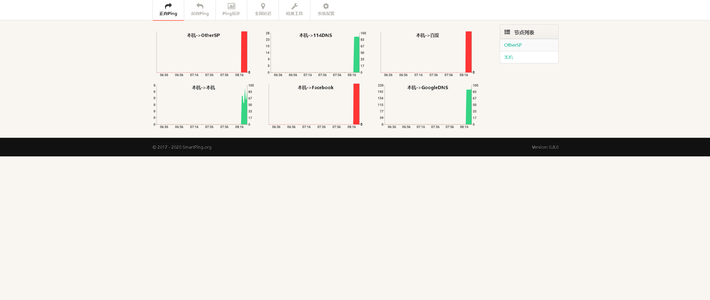

2、配置网络加速

目前要使用Docker,必须配置网络镜像,或者添加镜像加速库,在铁威马中目前有两种方法来实现。

1️⃣添加网络代理(推荐)

系统会自动让docker引用系统代理。

2️⃣配置镜像加速库(加速库要自己找)

正如刚才所说,我们必须修改daemon文件,因此需要先打开铁威马的SSH功能,默认的是9222端口。为了大家的网络安全,建议同时勾选仅允许本地网络内的SSH访问。

接着,我们通过ssh工具访问铁威马,输入指令cd /Volume1/@apps/DockerEngine/conf进入配置文件目录。

输入指令vim daemon.json进入编辑页面,整体的格式如下,可以修改registry-mirrors下的镜像加速地址来实现镜像下载加速。

{

"registry-mirrors": [

"https://docker.ketches.cn/",

"https://docker.1panel.live/",

"https://dockerpeoxy.net",

"https://docker.kejilion.pro"

]

}

修改完成以后,需要回去铁威马应用中心里,重启Docker Engine和Docker Manager两个应用。

二、修改dify配置文件

由于铁威马没有内置git,所以我直接把dify的配置文件放在网盘里,大家下载网盘下载exe格式的文件后解压缩,然后传到铁威马的目录下就可以。

🔻参照下图

里面的配置文件和环境变量我都修改好了,可以直接启用。如果需要修改的话,一般修改这两个地方。

🔻修改数据库透出端口,docker-compose.yaml文件第509行,左侧的25432可以修改为自己想要的。

🔻修改前端访问地址,修改.env文件第911行,18080是http的访问端口,18443是https的访问端口。

三、dify的部署和使用

1、部署dify

打开铁威马的Docker Manager,选择项目-新建。按照下图填写内容,并且将项目路径定位到/Volume1/path/dify-main/docker,在配置文件里选择目录下的docker-compose.yaml文件。

接着点击验证YAML和应用。如果配置好网络的,只要等一等,系统就会自动部署完成。

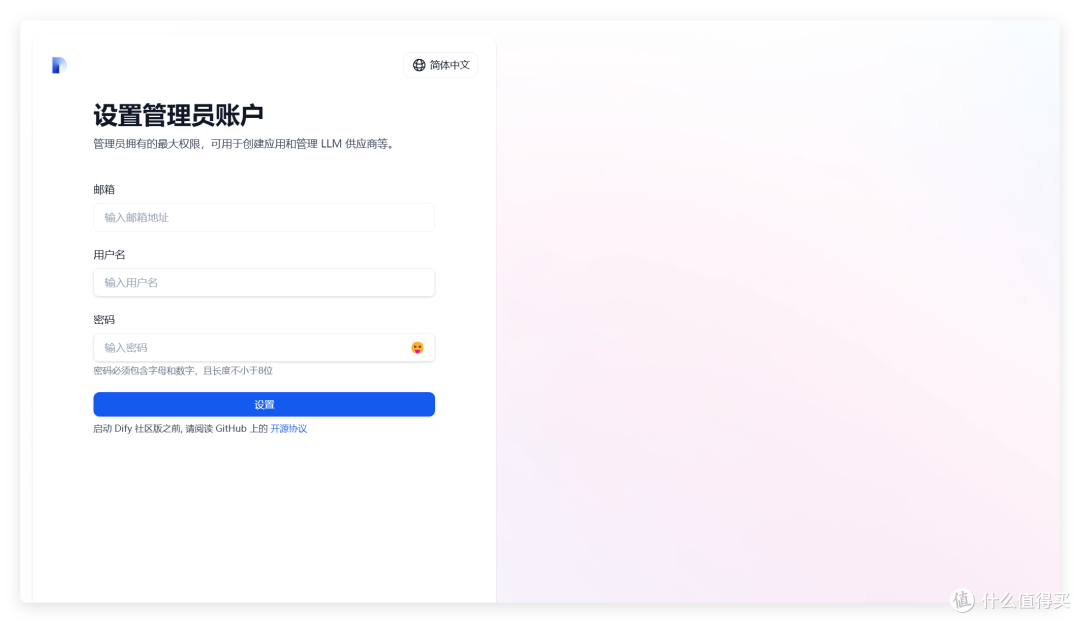

系统部署完成以后,回到浏览器,打开网址http://铁威马IP:18080就可以进入dify首页了。根据系统要求,配置个管理员账号密码进入。

2、dify配置插件和AI模型

进入系统后,选择插件一栏,在这里我们可以下载dify库中各式各样的插件。

点击右上角头像,选择设置进入模型设置。

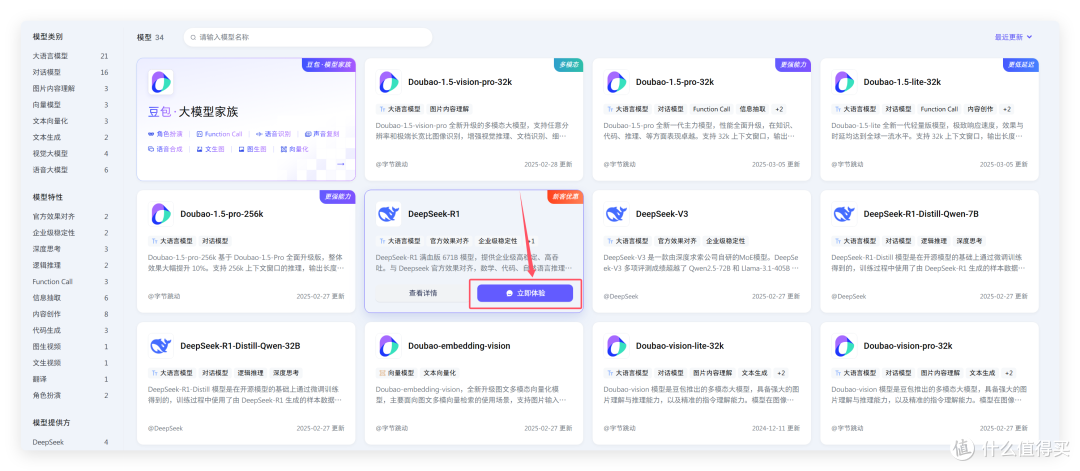

在这里可以安装数十个AI模型供应商的API 工具。我们比较推荐的是硅基流动、火山方舟这两个。

硅基流动免费的AI模型比较多,包括嵌入式的,在做知识库的时候很有用,唯一的缺点就是需要科学。而火山方舟目前是deepseek-R1最稳定的,自身的豆包也很强大,而且邀新各种送优惠券,基本等于白嫖。

3、注册火山并开通模型库

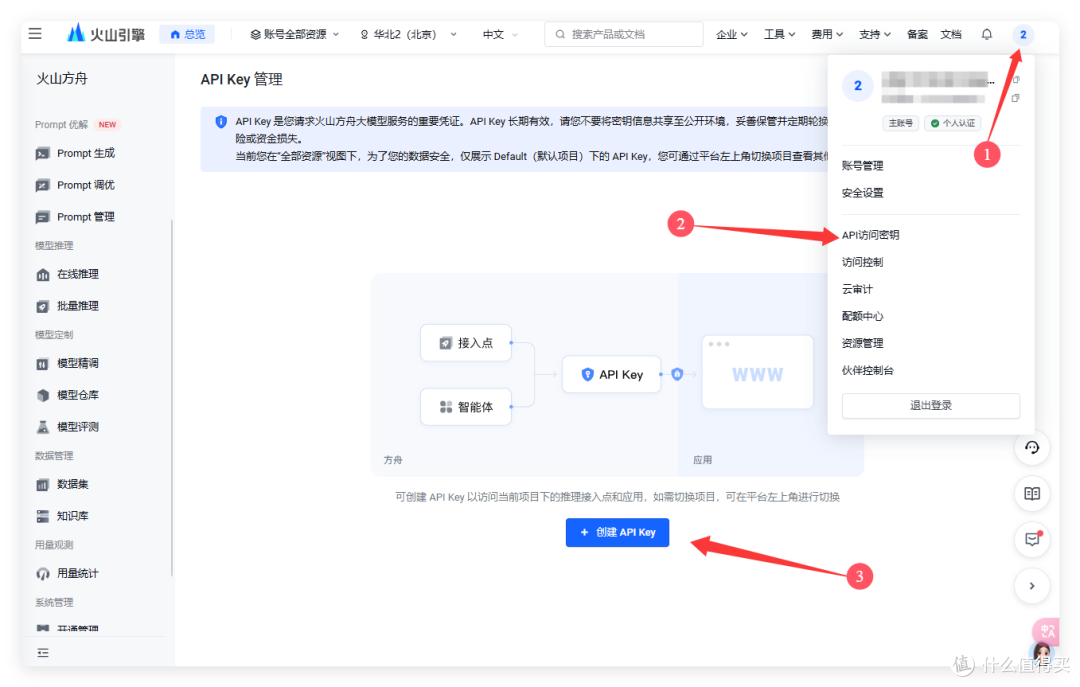

点击右上角头像,选择API访问密钥生成一个API KEY备用。

接着选择左侧的模型库,在里面选择如deepseek-r1,doubao-embedding等体验。

新界面选择API接入。

在右侧选择需要开通的API KEY,然后确认开通模型即可。很多人调用不了火山,就是这一步没操作。

回到导航栏左侧,选择模型推理—在线推理,这里每一个我们开通的模型都有Model ID,这个一会要填入dify中。

4、配置dify的AI 模型

回到dify,在安装好模型供应商以后,选择添加模型(硅基、ds、通义等只要配置API就行了,模型系统自带了)。

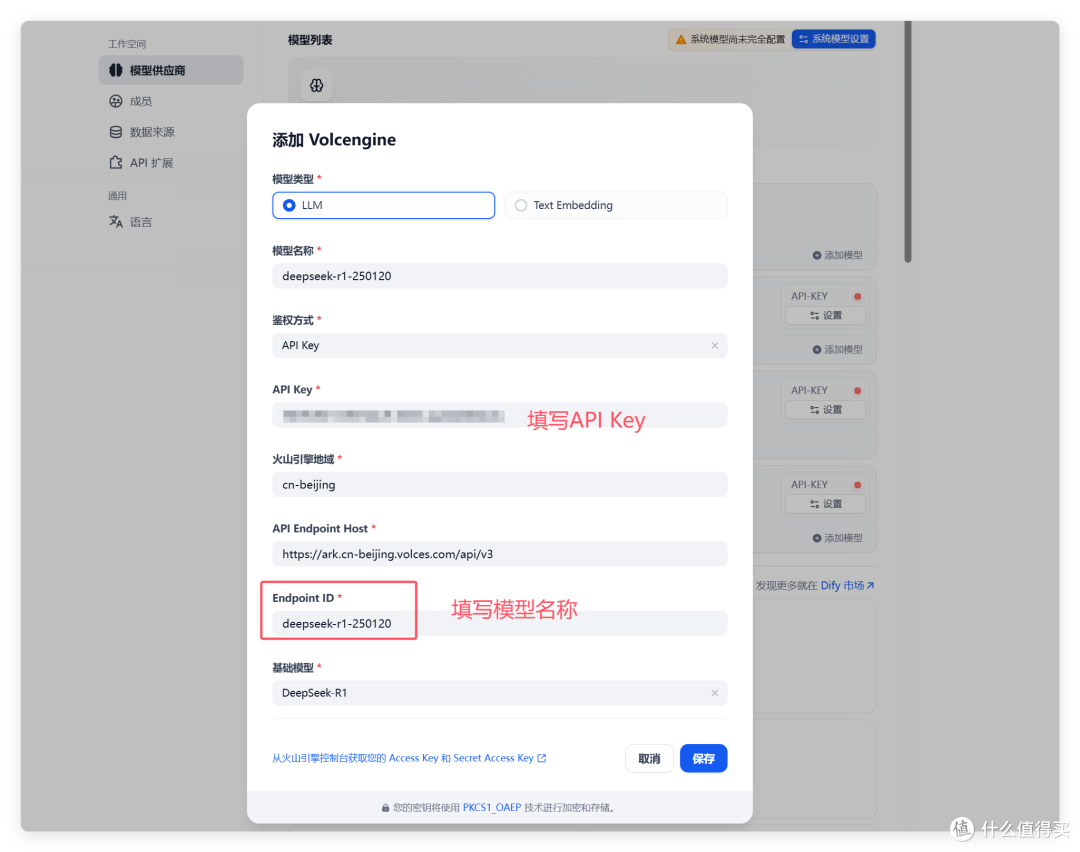

还是以火山为例,模型名称自定义;鉴权方式选择API KEY,并在下方填入;Endpoint ID填入模型名称;基础模型选择模型名称对应的内置模型名字,然后保存。

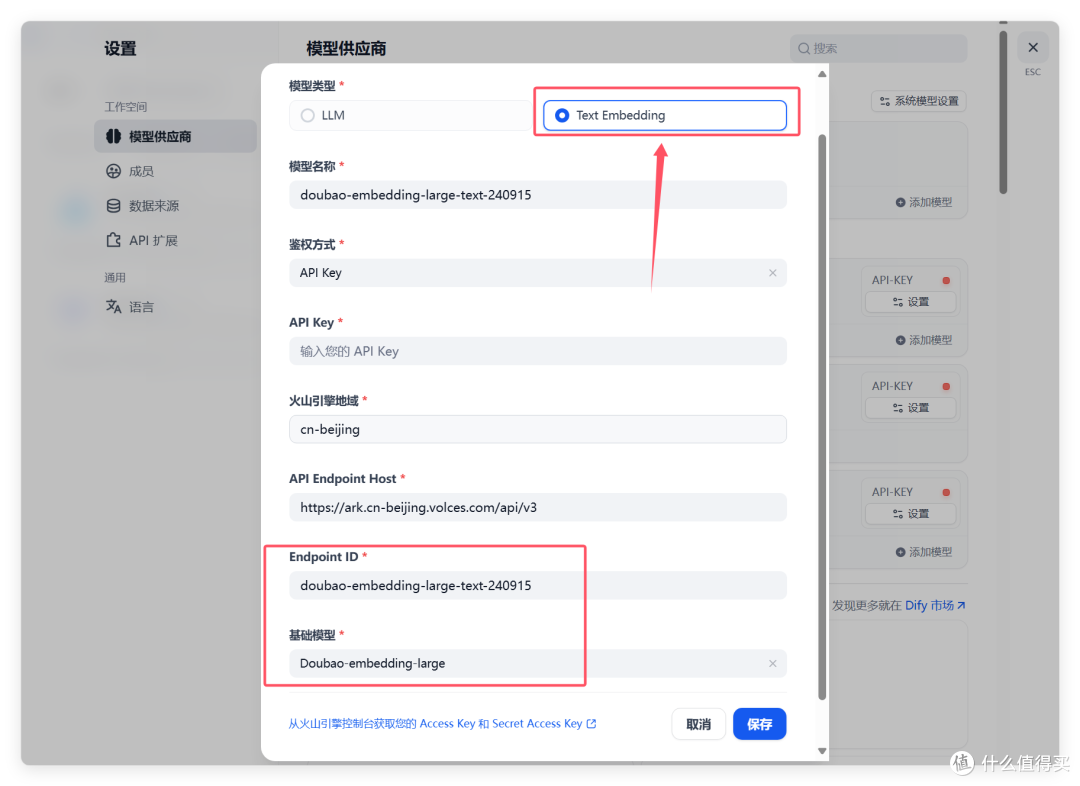

文本向量模型也是一样,建议选择doubao-embedding-large这一款,主要用作知识库内的文本向量分析。

配置完成以后,点击系统模型设置,在这里配置默认的模型种类。

5、使用dify

配置完成,我们就可以正式使用dify了,这里支持创建聊天助手、智能体(agent)、文本生成应用、工作流、Chatflow等。所有的应用都是无代码可视化搭建的。

创建完成以后,我们就可以分享自己的agent给外部使用,实现了AI驱动的工作流。

最后

在AI越来越便利的现在,NAS作为我们的家庭存储中心,除了存储这个本质工作外,也可以逐步向应用服务中心转变。

铁威马F6-424 MAX拥有强大的处理器性能,结合AI工作流工具Dify可以轻松实现强大的服务透出,帮助极客、初创团队搭建各式各样的AI工具,并且保持稳定、高质量的服务,从而实现一台设备,多种用途。

作者声明本文无利益相关,欢迎值友理性交流,和谐讨论~

avcd12601

我初步看了一下dify这个Agent框架,感觉像在本地集成多个ai api接口,方便调用。有一些问题,初学可能提得比较浅薄,比如我看火山方舟的api key,写着按token收费,虽然说是各种送优惠券,但是厂商能随意改策略,我以前就有不注意看消息不小心被厂商变政策收费的经历,感觉这是一个坑。火山方舟的优势就只是deepseek-R1稳定吗?我看dify的model providers就有原生集成的deepseek api key,可以直接调用deepseek-reasoner,这个对比火山的有什么劣势吗?

校验提示文案

值友6039938471

校验提示文案

我的曾曾曾曾祖父

校验提示文案

思念成殇

校验提示文案

都快忘了怎样恋一个爱

校验提示文案

都快忘了怎样恋一个爱

校验提示文案

思念成殇

校验提示文案

avcd12601

我初步看了一下dify这个Agent框架,感觉像在本地集成多个ai api接口,方便调用。有一些问题,初学可能提得比较浅薄,比如我看火山方舟的api key,写着按token收费,虽然说是各种送优惠券,但是厂商能随意改策略,我以前就有不注意看消息不小心被厂商变政策收费的经历,感觉这是一个坑。火山方舟的优势就只是deepseek-R1稳定吗?我看dify的model providers就有原生集成的deepseek api key,可以直接调用deepseek-reasoner,这个对比火山的有什么劣势吗?

校验提示文案

值友6039938471

校验提示文案

我的曾曾曾曾祖父

校验提示文案