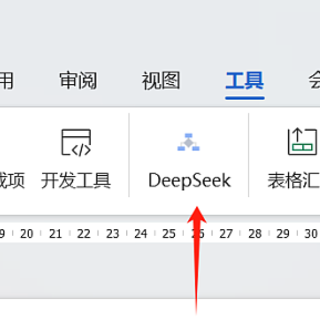

Mac mini m4 丐版本地部署 Deepseek r1 开源模型

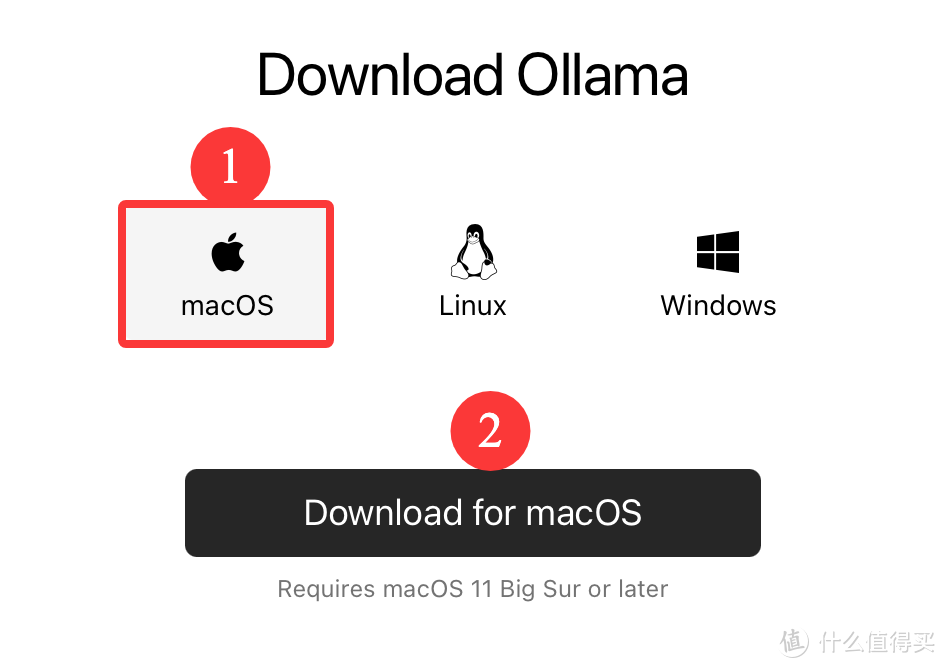

1.下载ollama。进入ollama官网https://ollama.com,直接点击download,download for macOS,下载完毕后正常安装。

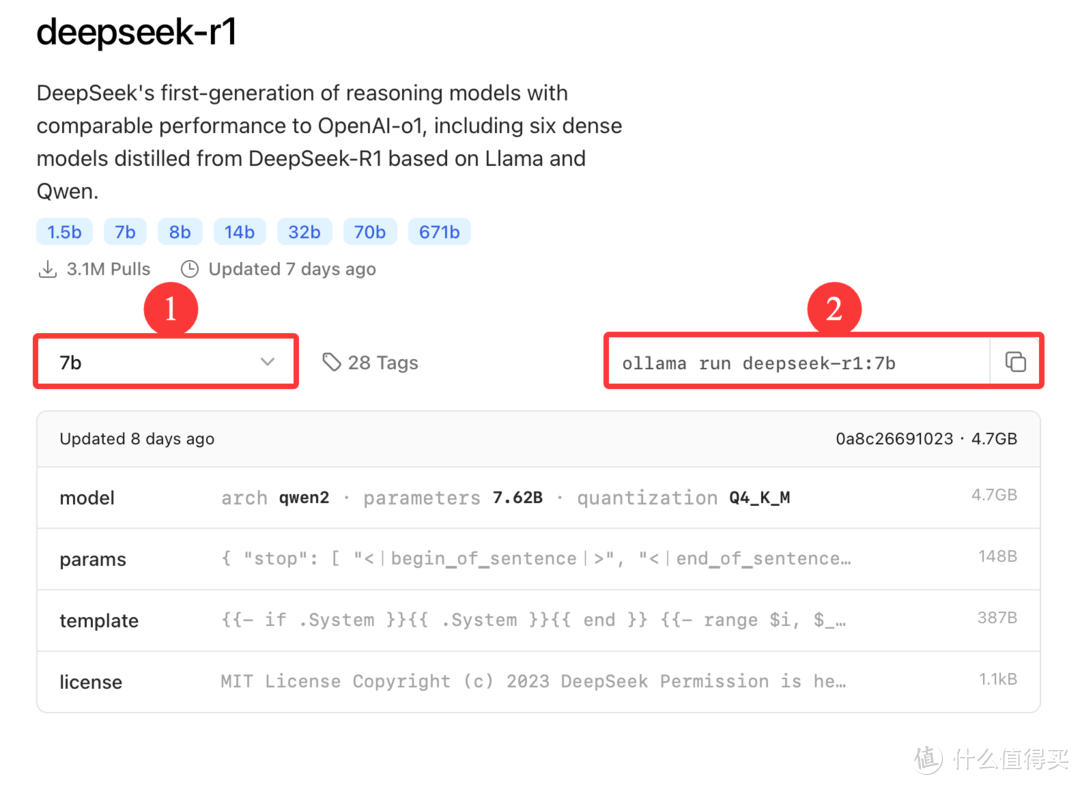

2.下载模型。在ollama官网顶端的搜索框输入“deepseek-r1”,进入之后默认选中的是“7b”模型,选择你想要的模型,丐版可以先选默认7b模型安装,后续熟练了可以测试其他模型是否可用。我最大测试过14b模型,相比小模型首次输出时间长一点,但可用。请自行尝试。选择完毕后右边自动给出命令,直接点击右边的复制按钮复制命令,然后“cmd + 空格”输入“终端”(打开“终端”),将复制的命令直接粘贴进去回车,即可开始下载。下载完成后直接可以在终端窗口中开启聊天。

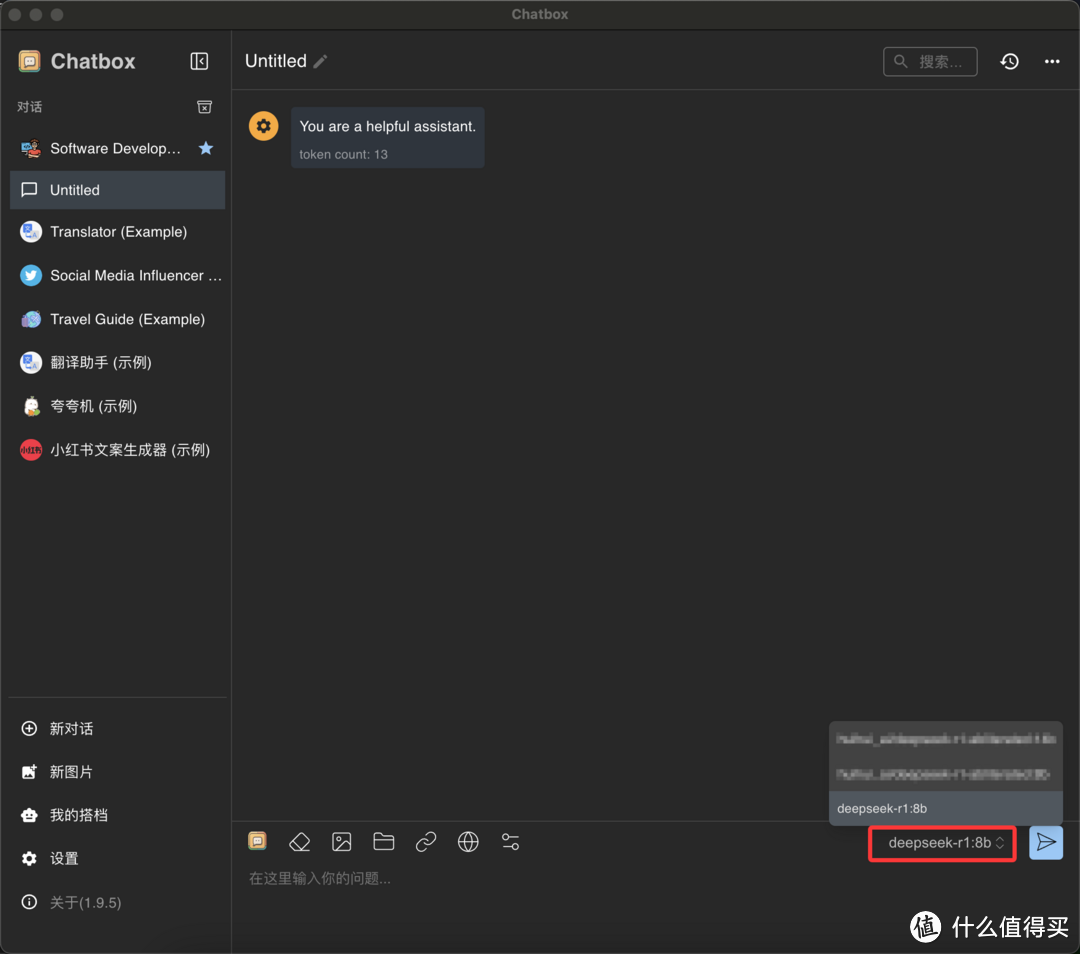

3.下载软件对接模型。进入chatbox官网https://chatboxai.app/zh,点击下载适用于Apple silicon版本的chatbox安装,安装完毕后会自动选中之前已经下载好的模型,可以直接和本地部署完成的模型对话。如果有多个模型,可以自行选择需要使用哪个模型,开始对话。

nostarnobucks

校验提示文案

踩过的坑

校验提示文案

天河之东

校验提示文案

天河之东

校验提示文案

nostarnobucks

校验提示文案

踩过的坑

校验提示文案